在科技日新月异的今天,人工智能领域再次迎来了重大突破。2024年中国生成式AI大会(上海站)于12月5日正式拉开帷幕,以“智能跃进 创造无限”为主题,吸引了众多行业精英和科技爱好者。在主会场首日的大模型峰会上,RockAI的首席技术官杨华发表了一场引人入胜的演讲,题为《非Transformer架构大模型Yan在端侧的实践》,揭示了生成式AI在端侧应用的新篇章。

长久以来,Transformer架构在大型语言模型领域占据主导地位,但其高昂的计算和内存成本,以及在某些任务上的特征提取局限性,引发了业界的广泛讨论。杨华在演讲中指出,面对这些挑战,RockAI从底层原理出发,进行了大胆的创新,推出了全新的非Transformer架构大模型——Yan架构大模型。

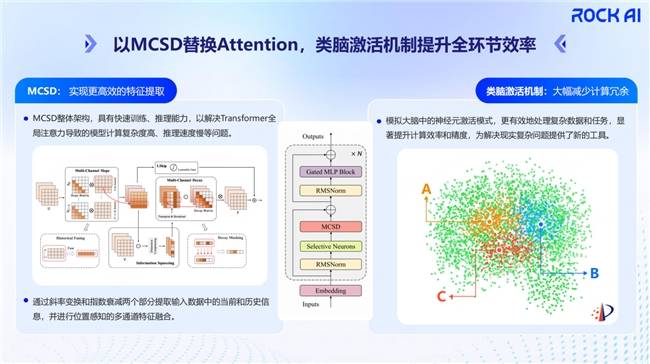

Yan架构大模型的核心在于两大基本原理:类脑激活机制和MCSD。类脑激活机制模仿人脑神经网络的分层结构,通过选择性激活神经元,大幅减少了计算冗余,提高了计算效率和精度。而MCSD则充分利用GPU的并行计算能力,在训练时降低功耗,在推理时实现了O(n)的时间复杂度和常量的空间复杂度,解决了内存占用逐渐增大的问题。

得益于这些创新,Yan架构大模型在端侧设备上展现出了强大的应用能力。无论是手机、电脑,还是机器人、无人机,甚至树莓派等低算力设备,都能轻松部署。模型不仅具备强大的指令跟随能力,还能在多应用场景中灵活切换,满足了多样化的需求。

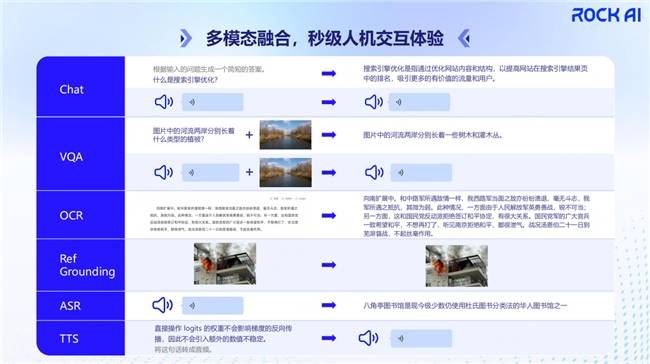

在演讲中,杨华还详细介绍了Yan架构大模型在端侧多模态应用方面的探索。基于Yan架构的自然语言大模型,RockAI开启了多模态的探索之旅,推出了Yan-Omni多模态大模型。该模型不仅理解文本,还能处理人声、图像和视频等混合模态的信息,实现了文本和音频的token输出。

Yan-Omni在多个任务上表现出色,如声音识别、视觉问答、OCR转录、目标检测以及ASR和TTS等。通过这些应用,我们可以看到Yan-Omni模型能够实现多模态的输入,以及文本和音频的选择性模态输出,为用户提供了更加自然和便捷的人机交互体验。

杨华还分享了RockAI在大模型领域对未来的思考。他认为,智能的本质在于能够纠正现存知识的缺陷和不足,同时增加新的知识。因此,RockAI致力于让Yan架构大模型具备自主学习的能力,实现训推同步。这一创新理念将人类学习进化的特点赋予机器,使模型在与物理世界的交互中不断进化。

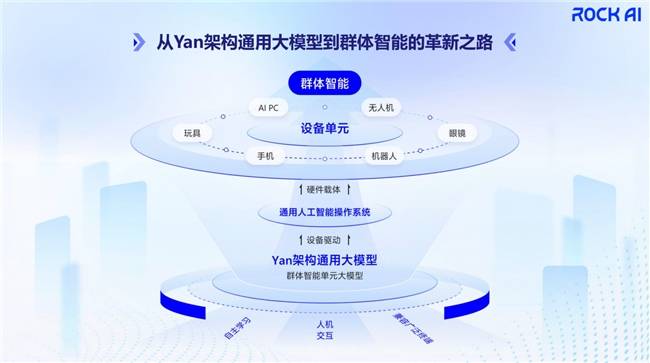

在杨华看来,群体智能是实现人工智能通用智能(AGI)的一条可能路径。当机器具备群体智能时,每一个部署Yan多模态大模型的智能终端都将成为一个具备自主学习能力的智能体。这些智能体在与物理世界的交互中能够自发组织、协作,解决复杂问题,并实现整体智能的提升。

为了实现这一目标,RockAI提出了三个必要条件:兼容广泛的终端设备、良好的人机交互以及具备自主学习能力的模型。只有在这些条件的共同作用下,群体智能才能成为可能。目前,RockAI已经在多个领域进行了尝试和探索,取得了显著的成果。

在演讲的最后部分,杨华介绍了RockAI迈向群体智能的四个阶段:架构重塑、单体推理、单体智能和群体智能。目前,RockAI已经迈过了前两个阶段,正在第三阶段进行沉淀和积累。随着技术的不断进步和应用场景的不断拓展,我们有理由相信,RockAI将在未来的人工智能领域创造更多的奇迹。