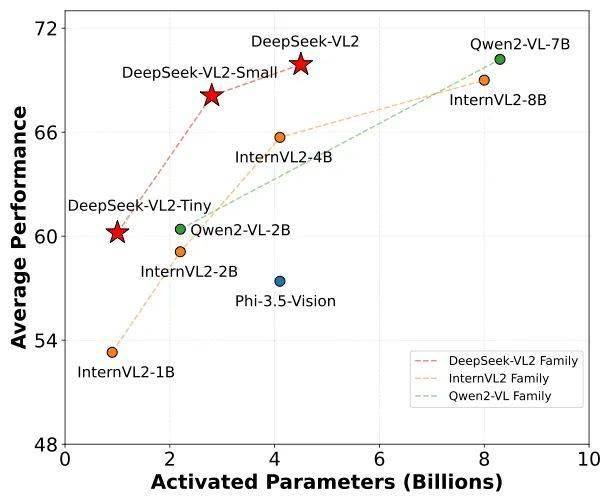

近日,DeepSeek 官方公众号发布了一则令人瞩目的消息,宣布其最新研发的 DeepSeek-VL2 模型已正式开源。据官方介绍,该模型在多项评测指标上均表现出色,标志着 DeepSeek 的视觉模型正式迈入混合专家模型(Mixture of Experts,简称 MoE)时代。

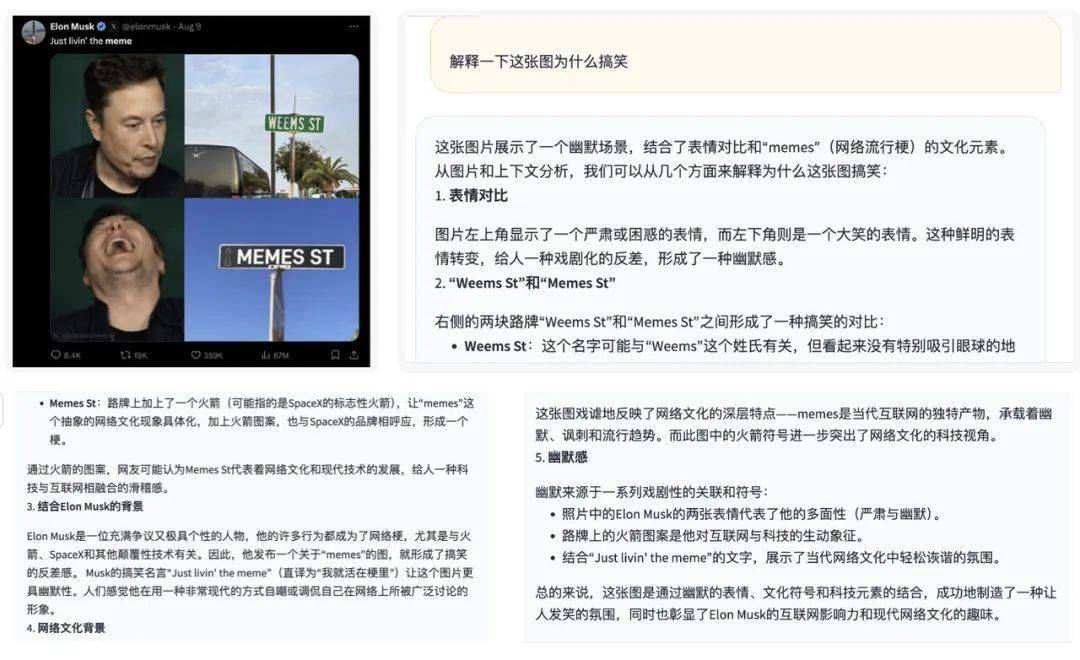

DeepSeek-VL2 相较于其前代 DeepSeek-VL,在训练数据上实现了翻倍的增长,并且引入了梗图理解、视觉定位、视觉故事生成等一系列新能力。这些改进使得 DeepSeek-VL2 在处理复杂视觉任务时更加游刃有余。

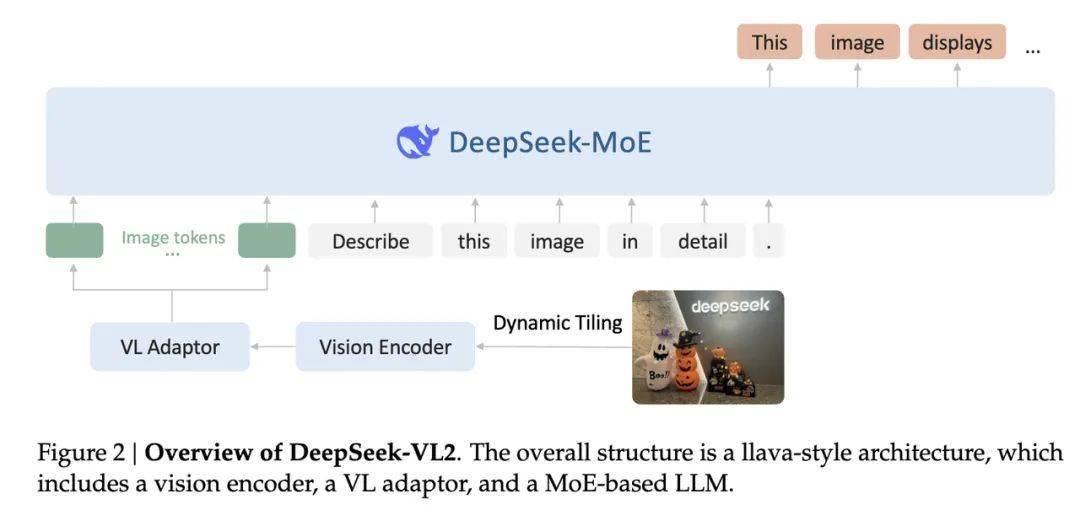

在架构方面,DeepSeek-VL2 采用了创新的切图策略,支持动态分辨率图像。这一策略通过将图像切分为多张子图和一张全局缩略图,实现了对不同分辨率和长宽比的图像的灵活处理。同时,在语言部分,DeepSeek-VL2 采用了 MoE 架构,不仅降低了成本,还提高了性能。

在训练流程上,DeepSeek-VL2 继承了 DeepSeek-VL 的三阶段训练方法,并进行了多项优化。为了适配图像切片数量不定的困难,DeepSeek-VL2 引入了负载均衡策略。同时,对图像和文本数据使用了不同的流水并行策略,对 MoE 语言模型引入了专家并行,从而实现了高效训练。

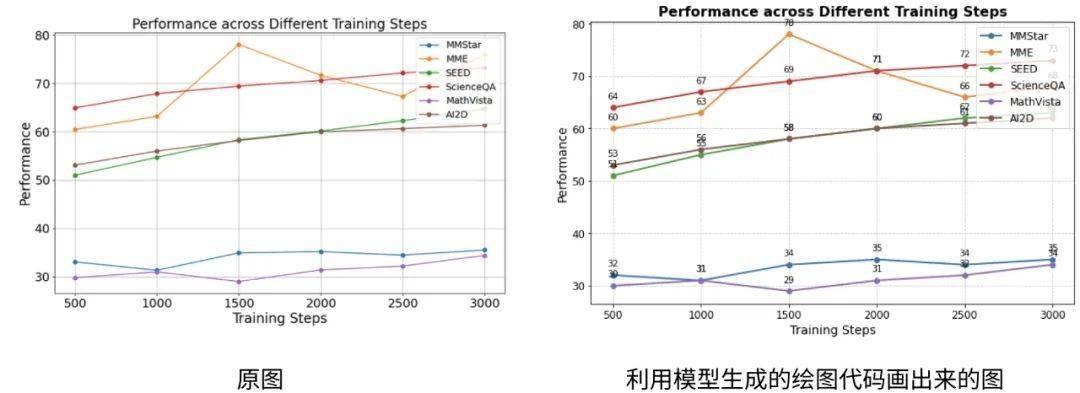

DeepSeek-VL2 模型支持高达 1152x1152 的分辨率和 1:9 或 9:1 的极端长宽比,这使得它能够适配更多应用场景。DeepSeek-VL2 还通过学习更多科研文档数据,具备了轻松理解各种科研图表的能力。更进一步的是,它还能通过 Plot2Code 功能,根据图像生成 Python 代码。

DeepSeek-VL2 的这些优势使其在多个领域都展现出了巨大的潜力。无论是图像处理、视觉定位还是代码生成,DeepSeek-VL2 都能够为用户提供更加精准、高效的服务。

目前,DeepSeek-VL2 模型和论文均已公开发布。用户可以通过以下链接下载模型和访问 GitHub 主页:

模型下载:https://huggingface.co/deepseek-ai

GitHub 主页:https://github.com/deepseek-ai/DeepSeek-VL2