国内开源大模型领域近日迎来新突破,大模型独角兽企业MiniMax在1月15日正式发布了其全新系列模型——MiniMax-01,并宣布该系列模型将全面开源。此次发布的MiniMax-01系列包含两款核心模型:一款是基础语言大模型MiniMax-Text-01,另一款则是视觉多模态大模型。

MiniMax-Text-01在性能上表现出色,据MiniMax官方介绍,该模型在多数任务上的表现已经与海外最先进的闭源模型GPT-4o和Claude 3.5 Sonnet相当。在评估模型指令遵循能力的IFeval和C-SimpleQA中文评测集中,MiniMax-Text-01的得分甚至超过了另一款国产开源模型DeepSeek-V3。这一成绩不仅彰显了MiniMax在技术研发上的实力,也进一步提升了国产开源大模型在全球范围内的竞争力。

在技术层面,MiniMax-01系列模型对传统的Transformer架构进行了创新。MiniMax在模型中首次大规模实现了线性注意力机制,每8层中有7层采用了基于Lightning Attention的线性注意力,仅有一层保留了传统的SoftMax注意力。这种创新使得模型在处理超长输入和需要快速处理的任务时更加高效。

线性注意力机制相较于传统注意力机制,其优势在于高效且计算量小。传统注意力机制需要逐一比较所有人的重要性,而线性注意力则只需查看每个人手中的名片,快速统计出哪些人持有的信息最重要。因此,线性注意力更适合处理超长输入和需要快速响应的任务。

MiniMax在技术报告中透露,他们正在研究更高效的模型架构,目标是完全去除SoftMax注意力机制,实现无限长的上下文窗口,同时不增加计算开销。这一研究将为未来的智能体应用提供更强大的技术支持。

与此同时,国内另一家AI公司DeepSeek也在12月底发布了其V3开源模型。DeepSeek-V3采用了创新的多头潜在注意力机制(MLA)和DeepSeekMoE混合专家架构,在节省内存占用和计算资源的同时,确保了资源的高效利用。DeepSeek-V3以极低的训练成本实现了与领军闭源模型相当的性能,引发了国内外科技社区的广泛关注和热议。

在模型训练和推理系统方面,MiniMax对MiniMax-01系列模型进行了全面重构。该模型包含4560亿个参数,单次推理激活459亿个,能够高效处理最长400万token的上下文,这一性能是GPT-4o的32倍,Claude 3.5 Sonnet的20倍。在长上下文的测评集上,MiniMax-Text-01的表现显著领先于其他开闭源模型。

MiniMax表示,01系列模型将能够满足未来一年内智能体应用的大幅增长需求。随着智能体系统对更长上下文处理能力和持续记忆的需求不断增加,MiniMax-01系列模型将为其提供坚实的技术支撑。MiniMax认为,2025年将是智能体高速发展的一年,他们希望在这个模型中走出第一步,并持续建立复杂Agent所需的基础能力。

智能体正成为国内外AI公司竞相押注的赛道。OpenAI CEO Sam Altman预测,到2025年,将可能看到第一批AI智能体“加入劳动力队伍”,并实质性地改变公司的产出。谷歌在推出新一代Gemini 2.0大模型时也表示,该模型是为智能体时代构建的,主打支持多模态输入和输出,以构建出更接近通用助手愿景的智能体。

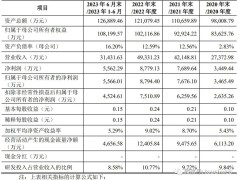

MiniMax在阐述为何选择将模型开源时提到,他们希望通过开源激发更多长上下文的研究和应用,从而更快促进智能体时代的到来。同时,开源也将促使他们不断进行创新,更高质量地开展后续的模型研发工作。MiniMax成立于2021年12月,被普遍称为国内“大模型六小龙”之一,其最新披露的一轮融资由阿里领投,公司估值已达25亿美元。

在“大模型六小龙”中,各公司的大模型开源进度不一。百川智能、智谱AI、零一万物等公司已开源了多款模型,涵盖大语言模型、多模态模型等。而月之暗面、阶跃星辰等公司则仅开源了部分技术。随着开源大模型领域的不断发展,国内AI公司的竞争将更加激烈,同时也将推动整个行业的技术进步和创新。