中国电信人工智能研究院近日宣布,其倾力打造的“复杂推理大模型”TeleAI-t1-preview已正式面世,并将很快在天翼AI开放平台上与公众见面。该模型采用先进的强化学习训练技术,通过引入探索与反思机制,显著提升了在逻辑推理与数学推导等复杂问题上的解答精度。

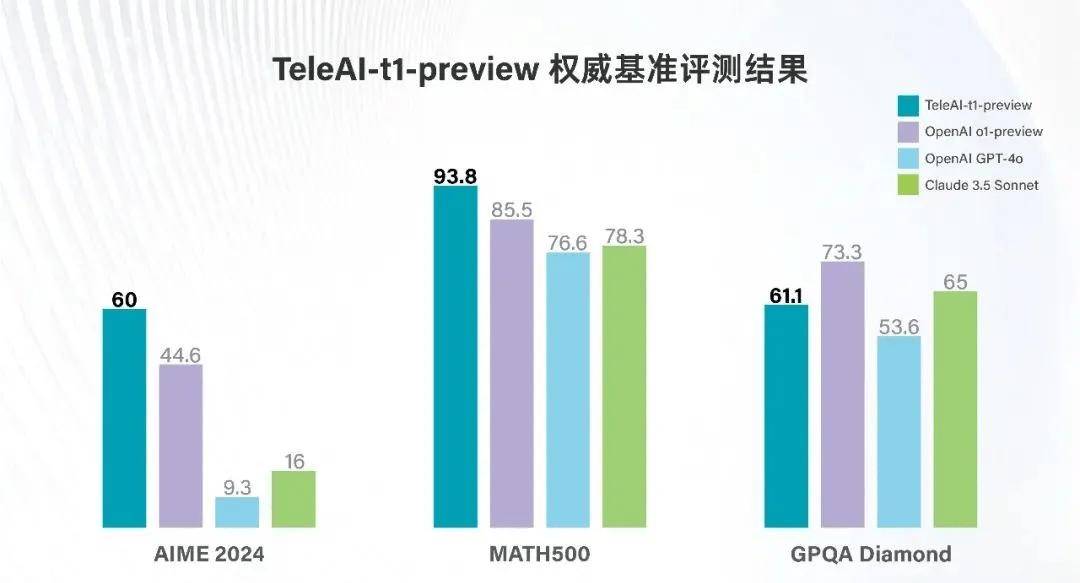

据官方介绍,TeleAI-t1-preview在美国数学竞赛AIME 2024与MATH500两项权威基准测试中,分别以60分和93.8分的优异成绩,远超OpenAI的o1-preview和GPT-4o等业界标杆模型。在研究生级别问答测试GPQA Diamond中,其表现同样出色,得分超越GPT-4o,与Claude 3.5 Sonnet的性能不相上下。

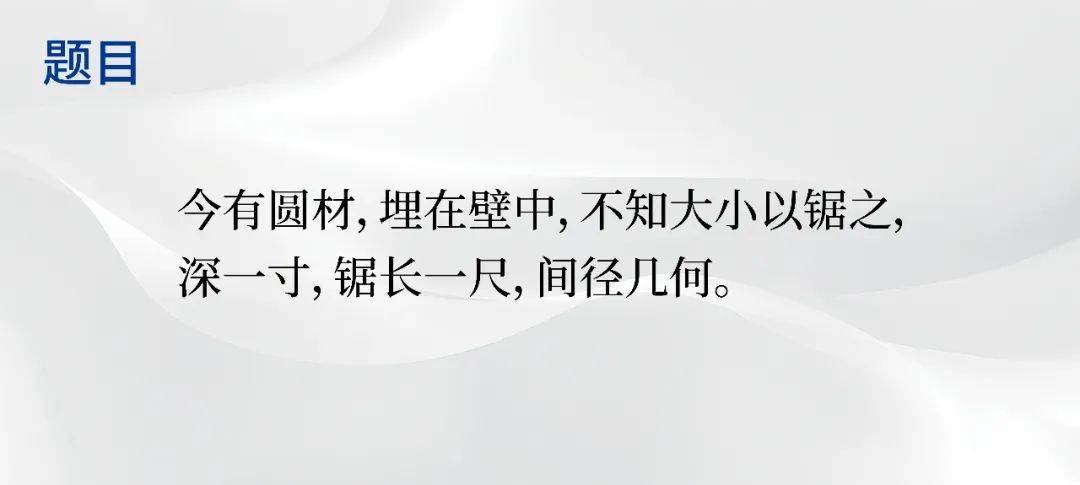

评测显示,TeleAI-t1-preview在处理《九章算术》中的题目时,能够先对文言文进行精准理解和简化,再转换成现代汉语,并给出详细的数学推导过程和答案。这一过程中,模型展现了将形象思维与抽象思维相结合的能力,对所涉及场景进行具象化思考,从而更好地理解题目。

尤为TeleAI-t1-preview还能严谨地进行古今单位换算,确保了答案的准确性。这一成就得益于中国电信人工智能研究院在模型训练策略上的创新。

在数据准备阶段,研究院收集并构建了一个以数学为核心、涵盖多学科的高质量推理数据集,为模型适应不同类型推理任务打下了坚实基础。还训练了一个专门的Judge Model,用于分析和评估模型长思考链路的正确性,为模型的反思和错误修正提供精准指导。

在监督微调(SFT)阶段,研究院采用蒙特卡洛树搜索(MCTS)构造高质量长推理数据,结合每个步骤的准确率和解决方案长度,选择最优完整路径。这不仅保证了推理答案的准确性,还有效拉长了思考链路,使推理过程更加细粒度。同时,利用Judge Model对推理过程中正确率较低的路径进行分析,引导模型对错误推理步骤进行反思和修正,从而构造出高质量的思维链数据进行SFT训练。

在强化学习阶段,研究院额外构造了基于规则的奖励模型(Rule-based Reward Model),提供准确奖励信号,通过在线强化学习算法进一步提升模型的逻辑推理能力。这一系列创新举措,共同成就了TeleAI-t1-preview在复杂推理领域的卓越表现。