随着GenAI时代的深入发展,大模型技术迭代加速,企业及用户对于AI能力的需求也日益升级。在这一背景下,多模态大模型正迅速落地,以其能听会说、响应迅速、支持随时打断等特点受到广泛关注。近期,MiniMax、商汤、豆包等主流大模型厂商纷纷对实时语音模型进行密集更新,进一步推动了这一趋势。

面对AI交互体验不断升级的大环境,声网凭借在对话式智能体搭建和用户体验方面的深刻理解,推出了Conversational AI Engine(对话式AI引擎)。该引擎具备超低响应延迟、优雅打断、对话人声锁定以及全5A适配等核心优势,为用户带来更加自然流畅的交互体验。

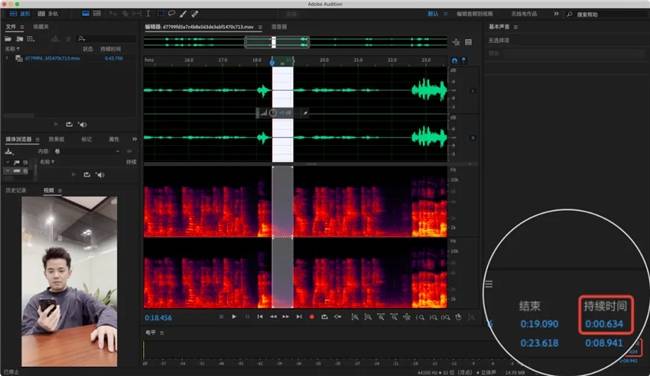

其中,超低响应延迟是声网Conversational AI Engine的一大亮点。经过实测,该引擎的响应延迟中位数仅为650毫秒,远低于行业平均水平。如下图所示,声网在实际测试中展现了其卓越的响应速度。

除了超低延迟外,声网Conversational AI Engine还具备全模型适配的核心优势。该引擎突破了传统框架的限制,基于全球主流的Conversational AI Agents开源框架TEN framework构建,支持第三方云端大模型服务、企业私有化模型及本地化部署的开源模型无缝接入,实现了跨架构模型的敏捷适配。

为了进一步提升用户体验,声网Conversational AI Engine还提供了零改造接入体验。依托标准化API,无论是新模型还是老模型,都可以实现一键式快速接入,大大缩短了接入周期,有效保障了企业AI模型资产的无损迁移与持续价值转化。

在真实语音对话场景中,打断对方并提出新疑问是常见现象。声网自研的AI VAD技术,能够适应人类对话的停顿、语气和节奏,支持在AI对话过程中随时优雅打断。这一技术不仅提升了对话的流畅性,更体现了声网对于用户需求的深刻理解。通过相关视频,我们可以直观地看到声网方案的优雅打断效果。

针对大模型语音交互中存在的误打断痛点,声网技术团队结合多年积累的AI降噪等音频对话处理能力,智能屏蔽交互中的背景人声与噪声干扰。即使在商场、地铁站等嘈杂环境中,也能保证对话应答的精准与流畅。据测试对比显示,在噪杂环境下,声网的方案误打断率较ChatGPT降低了50%。

在网络环境不稳定的情况下,如何保障交互的稳定与流畅,是AI企业面临的一大挑战。声网凭借在音视频领域的深厚技术优势与场景实践,通过实时网络覆盖、网络超强适应以及海量终端适配等优势,打造了全球一致的端云覆盖体验。即使在面临80%丢包的情况下,人与Agent也能稳定交流。

考虑到用户硬件设备的差异可能对语音处理效果产生影响,声网的RTC SDK支持30+平台开发框架以及30000+终端机型适配,覆盖了广泛的中低端机型。这一举措解决了AI厂商在多设备兼容性方面的后顾之忧,为用户提供了统一的低延时传输体验。

声网Conversational AI Engine作为行业首个实现650毫秒超低延时响应的对话式AI解决方案,其自研AI VAD技术、智能打断效果以及音频技术改进均处于行业领先地位。整体方案助力人与Agent的互动更加自然流畅,为用户带来了更加卓越的AI交互体验。目前,声网Conversational AI Engine已开放Private Beta版本邀请测试,欢迎广大用户咨询体验。