OpenAI近期启动了一个为期12天的创新发布周期,命名为“shipmas”,旨在推出一系列令人瞩目的新功能、产品及演示。在这一系列发布活动的第二天,OpenAI揭晓了强化微调(Reinforcement Fine-Tuning, RFT)技术,为开发者和机器学习工程师提供了一个强大的工具,用于构建针对特定复杂领域任务的专家级模型。

强化微调项目通过引入全新的模型定制技术,允许开发者利用高质量的任务集对模型进行微调。这一过程中,开发者可以利用参考答案来评估模型的响应,从而显著提升模型在特定领域任务中的推理能力和准确性。这一技术的出现,为模型在特定领域的表现带来了质的飞跃。

根据OpenAI的官方介绍,开发人员现在可以使用从数十到数千个的高质量任务来定制OpenAI的模型,并通过提供的参考答案对模型的响应进行评分。这一创新技术不仅强化了模型推理类似问题的方式,还显著提高了其在特定领域任务上的准确性。通过这一方法,模型能够更精准地理解和解决复杂问题。

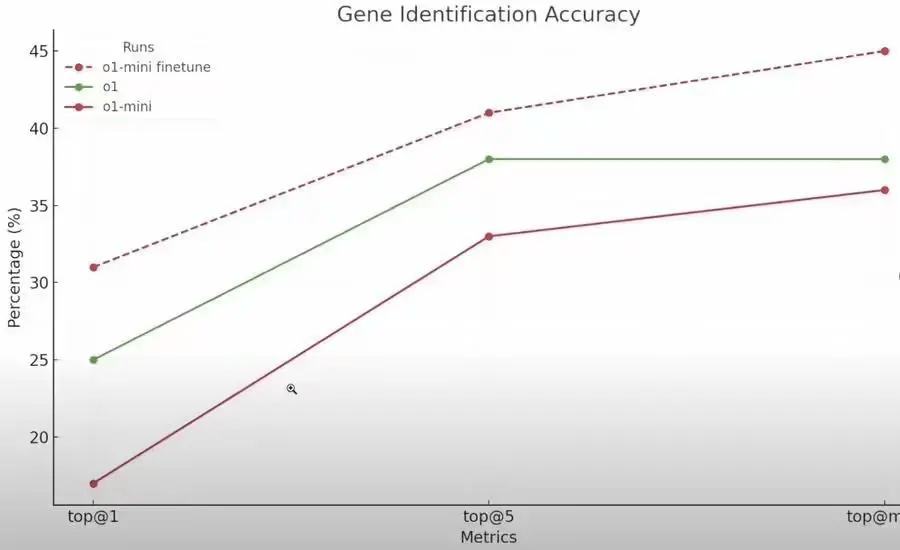

与标准微调方法不同,强化微调利用强化学习算法,将模型的性能从高中水平提升至专家博士级别。这一技术不仅仅是对模型进行简单的模仿训练,而是通过让模型学习全新的推理方式,并通过评分机制强化正确的推理路线,从而仅使用少量示例就能显著提高模型的性能。

强化微调技术的另一个显著优势是,它支持用户利用自己的黄金数据集创建独特的模型,并将其应用于法律、金融、工程、保险等需要深厚专业知识的领域。这一技术为这些领域的专家提供了一个强大的工具,使他们能够更有效地利用人工智能辅助完成复杂任务。

OpenAI特别鼓励研究机构、高校和企业申请使用这一技术,特别是那些目前由专家领导执行一系列狭窄但复杂任务的机构。OpenAI认为,强化微调在结果具有客观“正确”答案且大多数专家会达成一致的任务中表现出色,因此在法律、保险、医疗、金融、工程等领域具有广阔的应用前景。

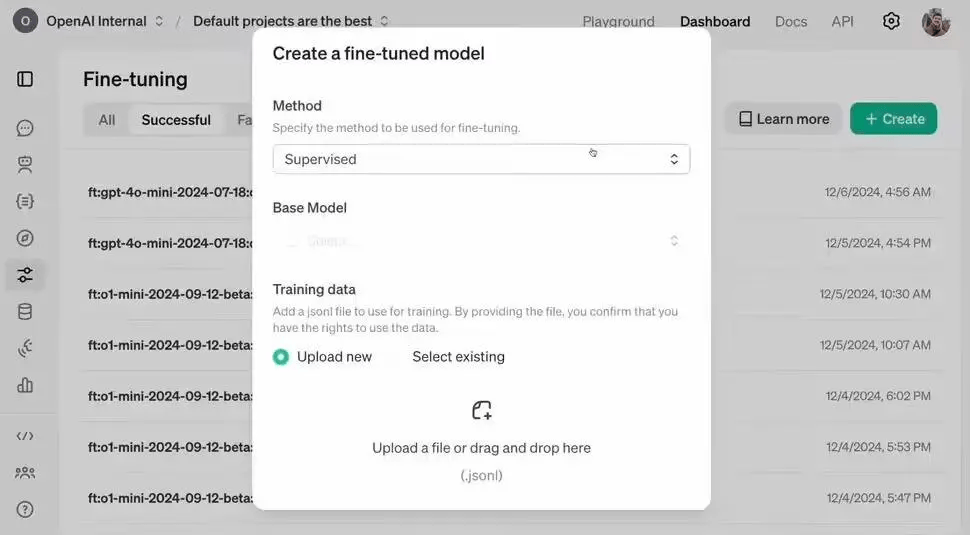

参与者可以提前访问Alpha版的强化微调API,并在特定领域任务中进行测试。OpenAI还鼓励参与者分享自己的数据集,以共同改进OpenAI的模型。这一举措不仅促进了技术的迭代升级,还加强了行业内的合作与交流。

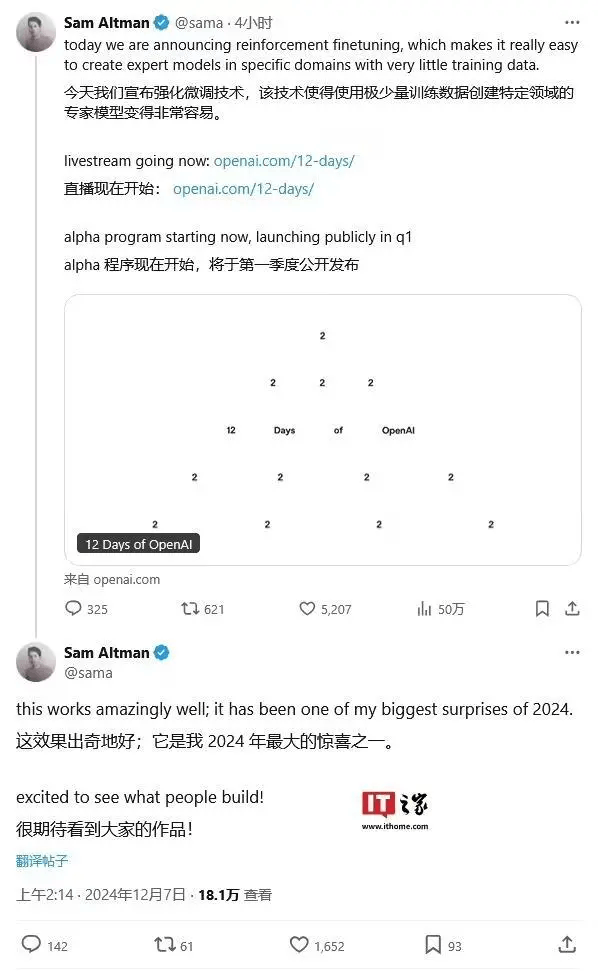

OpenAI预计将在2025年初公开发布强化微调功能。OpenAI的首席执行官山姆·阿尔特曼对这一技术表示了高度赞赏:“强化微调的效果出奇地好,它是我2024年最大的惊喜之一。”这一技术的推出,无疑将为人工智能领域的发展注入新的活力。