在人工智能领域,提升大语言模型的推理能力一直是科研探索的关键方向。近期,DeepSeek-R1模型通过一种创新的强化学习方法,实现了推理能力的显著提升,且这一过程无需人工标注的介入。该模型独特的自我反馈机制,使其能够高效处理复杂的推理任务,包括数学难题和编程逻辑。

DeepSeek-R1的训练流程匠心独运,分为两个核心阶段。在“冷启动”阶段,模型利用精心挑选的高质量样本进行微调,以此提升推理的准确性和清晰度。随后,在强化学习阶段,通过严格的低质量输出筛选机制,进一步增强了其推理效能。模型还融入了巧妙的数据混合策略,有效促进了特定领域能力的提升,从而在低人工干预的条件下,实现了对复杂问题的有效解决。

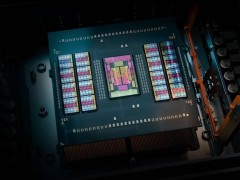

为了将DeepSeek-R1模型应用于实际场景,本地部署成为了一个重要环节。在这一过程中,选择一款性价比出众的开发板至关重要。传统高性能主板如Jetson Orin和Nano虽性能卓越,但高昂的价格和较大的体积限制了其应用范围。相比之下,DFRobot LattePanda Mu开发板以其微型x86计算模块、Intel N100四核处理器、8GB LPDDR5内存和64GB存储空间,展现出强大的深度学习任务处理能力。其丰富的扩展接口和开源载板设计,更为项目的灵活定制提供了无限可能。

在框架选择上,为了实现DeepSeek-R1模型的高效加载和执行,Ollama框架凭借其便捷性和高效性脱颖而出,成为推荐的本地部署方案。用户只需在Ollama官网下载安装,并根据自身硬件性能和实际需求,选择合适的模型参数大小。对于未配备专业级显卡的用户,推荐使用14B以内的模型。

在硬件配置方面,不同参数大小的DeepSeek-R1模型对机器的要求各不相同。例如,DeepSeek-R1-Distill-Qwen-32B模型需要约14.9GB的VRAM,推荐配置为NVIDIA RTX 4090 24GB显卡和至少32GB的RAM。而DeepSeek-R1 671B完整模型则对硬件提出了更高要求,需要约1,342GB的VRAM(使用FP16精度),推荐采用多GPU设置,如NVIDIA A100 80GB × 16,并配备512GB以上的RAM和500GB以上的高速SSD。对于671B模型,还需考虑功耗和散热等额外因素。

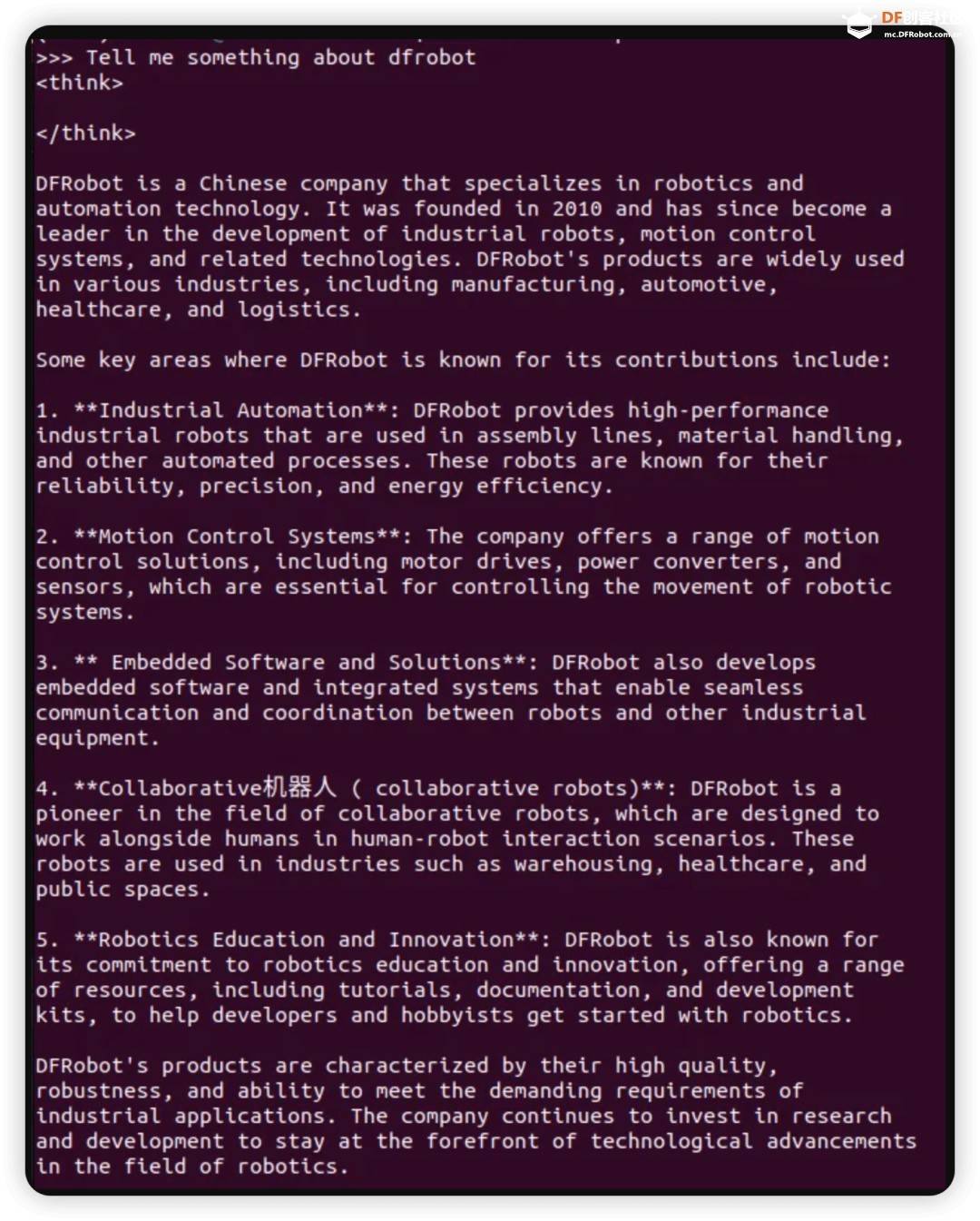

在成功安装框架并选择合适的硬件配置后,即可运行DeepSeek-R1蒸馏模型。Ollama官方提供了计算推理速度的工具,用户只需在聊天窗口输入特定指令,即可在每次回复后自动输出运行速度。这一功能为用户提供了直观的性能评估手段。

随着技术的不断进步,小型计算平台如LattePanda Mu在边缘计算和定制化应用中展现出巨大潜力。DeepSeek模型的强大推理能力,为这些平台注入了新的活力。在数据库查询、文本理解等智能应用领域,DeepSeek展现出了卓越的性能。未来,随着LattePanda Mu和DeepSeek的持续优化,开发者将能够在各种硬件环境中更加高效地利用深度学习和大语言模型,推动智能应用的不断创新与发展。