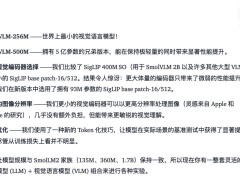

近日,Hugging Face 推出了两款创新的多模态模型——SmolVLM-256M和SmolVLM-500M,这两款模型在视觉与语言处理领域引起了广泛关注。其中,SmolVLM-256M更是被誉为全球最小的视觉语言模型,这一突破性的成就令人瞩目。

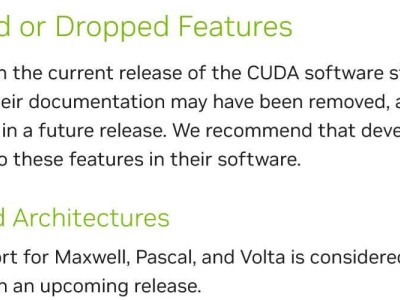

据了解,这两款模型均源自Hugging Face团队去年训练的庞大800亿参数模型,通过精心的蒸馏技术提炼而成。它们成功地在高性能与资源效率之间找到了完美的平衡点。官方强调,无论是SmolVLM-256M还是SmolVLM-500M,都无需复杂配置,即可“即插即用”,轻松部署在transformer MLX和ONNX平台上。

从技术细节来看,SmolVLM-256M和SmolVLM-500M均采用了SigLIP作为图像编码器,而文本编码任务则交由SmolLM2完成。SmolVLM-256M以其小巧的体积脱颖而出,成为目前最小的多模态模型。它能够接收任意序列的图像和文本输入,并生成相应的文字输出,功能涵盖图像描述、视频字幕生成、PDF处理等。尤为该模型体积小巧,即便在移动平台上也能流畅运行,仅需不到1GB的GPU显存即可完成单张图像的推理任务。

相比之下,SmolVLM-500M则针对高性能需求进行了优化。Hugging Face表示,这款模型非常适合企业运营环境,尽管其资源需求略高于SmolVLM-256M,但在推理输出的精准度上有了显著提升。具体来说,SmolVLM-500M在处理单张图像时,仅需1.23GB的GPU显存。

这两款模型均遵循Apache 2.0开源协议,研究团队还提供了基于transformer和WebGUI的示例程序,以便开发者快速上手。目前,所有模型及其演示均已公开发布,开发者可以轻松下载并使用,具体访问页面请点击此处。