在人工智能技术日新月异的今天,DeepSeek凭借其开创性的算法框架、低廉的训练与推理成本、开放的源代码策略以及广泛的应用前景,正在全球范围内掀起一股新的AI热潮。无论是新兴行业还是传统领域,众多企业都在积极探索如何将DeepSeek的能力融入自身业务,而在这场AI变革的背后,算力平台的选择成为了关键。

作为国内率先支持DeepSeek-R1模型的云服务提供商,天翼云一直致力于为企业提供强大的云网算力支持。依托CPU的卓越性能、显著的成本效益以及便捷的使用体验,天翼云为众多用户的“DeepSeek之旅”铺设了一条算力“快车道”。

企业在布局大型AI模型时,常常面临算力的“不可能三角”难题:性能、成本与部署灵活性难以同时满足。传统GPU方案虽然能提供高性能,但高昂的成本和大规模集群的需求却构成了技术门槛高、资源消耗大的发展瓶颈。这导致许多企业在AI转型初期或在尝试部署DeepSeek时,因算力投入的压力而陷入困境,只能对先进的AI模型望洋兴叹。

以DeepSeek R1 671B满血版为例,该模型性能卓越,能为用户提供极致的AI体验,但其部署成本也不容忽视。若采用传统的GPU方案,用户至少需要投入数百万元用于硬件采购、机房建设和运维,这对于众多中小企业而言无疑是一笔沉重的负担。

针对企业多样化的AI需求,天翼云推出了规格多样、性能出色、配套完善的CPU云主机产品,打破了商用算力成本高昂的壁垒,为企业提供成本更低、部署更高效的算力解决方案,助力企业基于DeepSeek模型进行AI业务的升级。

天翼云第八代弹性云主机凭借其卓越的计算性能、高效的能源效率、强大的安全性和可靠性以及广泛的兼容性,为用户带来了全新的云计算体验。尤其在AI加速方面,该云主机的每个物理内核都具备AI加速功能,可直接对大参数量的AI模型进行推理和调优。例如,一台24C48G规格的天翼云第八代弹性云主机,在搭载60G通用SSD系统盘和1M公网带宽,并启用第五代英特尔® 至强® 可扩展处理器内置的高级矩阵扩展(AMX)加速后,DeepSeek 7B蒸馏模型(BF16)的推理速度能超过9 token/s,平均Token生成速率提升21%。这不仅能满足大部分日常AI应用场景的需求,而且成本更低。

天翼云CPU主机还支持多个DeepSeek蒸馏版本,内置一键部署的云主机镜像,并预装了包括DeepSeek-R1-Distill-Qwen-7B、DeepSeek-R1-Distill-Qwen-14B和DeepSeek-R1-Distill-Qwen-1.5B在内的多个模型,以及vLLM推理框架、开源的AI推理框架xFasterTransformer(xFT)加速库和Open WebUI前端可视环境。用户只需在天翼云控制台选择相应的资源池和镜像,即可轻松开通云主机,一键部署DeepSeek大模型进行业务应用。

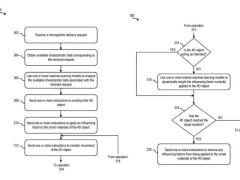

DeepSeek R1 671B满血版作为DeepSeek的“性能王者”,以其卓越的性能为用户带来了极致的体验。然而,对于企业而言,部署满血版所需的硬件购置、能耗以及维护等成本也是一笔不小的开支。为此,天翼云通过深入分析模型的算法与架构,寻找最佳的算力匹配方案。

DeepSeek R1模型采用稀疏注意力机制和混合专家模型(MoE)架构,通过参数稀疏化的方式,使得在单token推理时仅需激活少量专家参数。这一特性显著降低了推理过程中的算力要求,与CPU的计算特点相契合,使得模型在CPU系统上的运行更加高效。天翼云基于全新一代X86处理器,搭配高级矩阵扩展AMX,对DeepSeek-R1-671B(Q4_K_M社区量化版)进行了部署测试。测试结果表明,在单实例单socket(128核)模式下,DeepSeek-R1-671B在上述CPU平台上可达到平均9.7~10 token/s的吞吐量,而在单机双实例部署模式下,总体吞吐量可提升至14.7 token/s。这意味着单颗CPU构建的服务吞吐性能即可满足普通用户的日常使用需求,天翼云CPU云主机的通用计算型规格在成本和便捷性上展现出显著优势。

实践证明,天翼云第八代弹性云主机的CPU系统不仅能够充分发挥DeepSeek大模型的性能优势,还能有效降低部署成本,减少对大量传统GPU的依赖。无论是处理轻量化蒸馏模型还是全功能满血模型,天翼云CPU云主机都能灵活应对不同规模的模型需求,高效满足用户场景,提供低成本且高效的解决方案。