在科技界的瞩目之下,OpenAI于近日凌晨的直播活动中震撼发布了其最新的o3与o4-mini模型,标志着人工智能领域又迈出了重要一步。

据OpenAI官方介绍,这两款新模型是o系列中的最新力作,它们在回答问题前能够进行更为深入的思考。OpenAI自豪地宣称,o3与o4-mini是其迄今为止发布的最智能的模型,这一突破将为从好奇用户到高级研究人员的广泛群体带来显著益处,标志着ChatGPT能力的一次巨大飞跃。

尤为引人注目的是,新的推理模型能够智能地运用和结合ChatGPT中的各项工具,包括网络搜索、Python数据分析、视觉输入深度推理,甚至图像生成。这些模型经过专门训练,能够判断何时以及如何使用这些工具来生成详尽且经过深思熟虑的答案,通常只需不到一分钟,便能解决更为复杂的问题。这一能力使得它们在处理多方面问题时更加高效,向更加智能、能够独立执行任务的ChatGPT迈进了一大步。

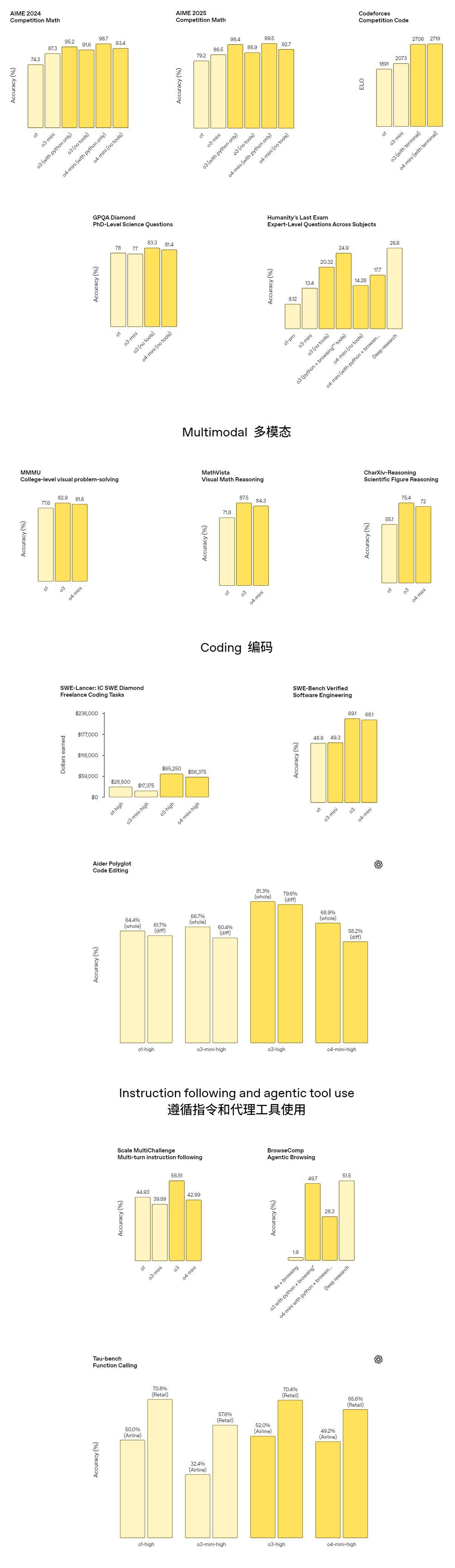

在性能表现方面,o3被誉为OpenAI最强大的推理模型,在编码、数学、科学、视觉感知等领域均处于领先地位,并在多个基准测试中创造了新的SOTA记录。OpenAI指出,o3特别适合处理需要多方面分析和答案可能不明显的高级查询,尤其在分析图像、图表和图形等视觉任务上表现出色。在外部专家的评估中,o3在复杂现实任务上的表现优于OpenAI o1,减少了20%的重大错误,特别是在编程、商业咨询和创意构思等领域。

与此同时,o4-mini则是一个专为快速、成本效益高的推理而优化的较小模型。它在数学、编码和视觉任务上取得了令人瞩目的性能,尤其是在提供Python解释器的情况下,在AIME 2025竞赛中得分高达99.5%。在专家评估中,o4-mini在非STEM任务以及数据科学等领域相比其前身o3-mini也展现出了更出色的表现。得益于其高效率,o4-mini支持更高的使用限制,成为处理推理问题的强大高容量、高吞吐量选项。

与OpenAI的前几代推理模型相比,o3和o4-mini在对话自然度方面也有了显著提升,特别是在参考记忆和过去对话来使响应更加个性化和相关时。这两个模型能够更自然地融入对话,为用户提供更加流畅和智能的体验。

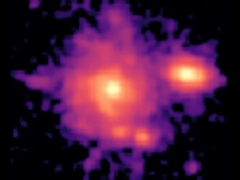

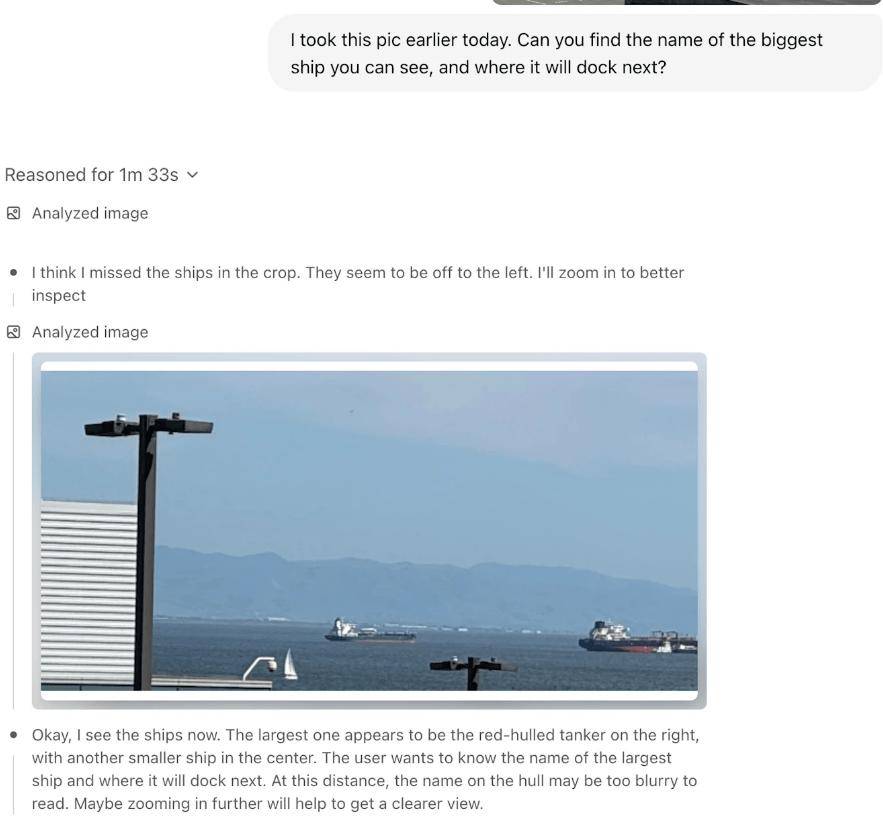

这些新模型还具备直接整合图像到思维链中的能力。它们不仅仅是查看图像,而是能够用图像进行思考,这解锁了一种新的问题解决类别,融合了视觉和文本推理。用户可以上传白板照片、教科书图表或手绘草图,即使图像质量不佳,模型也能解读并进行分析。通过使用工具,模型甚至可以实时操作图像,如旋转、缩放或变换,以作为推理过程的一部分。

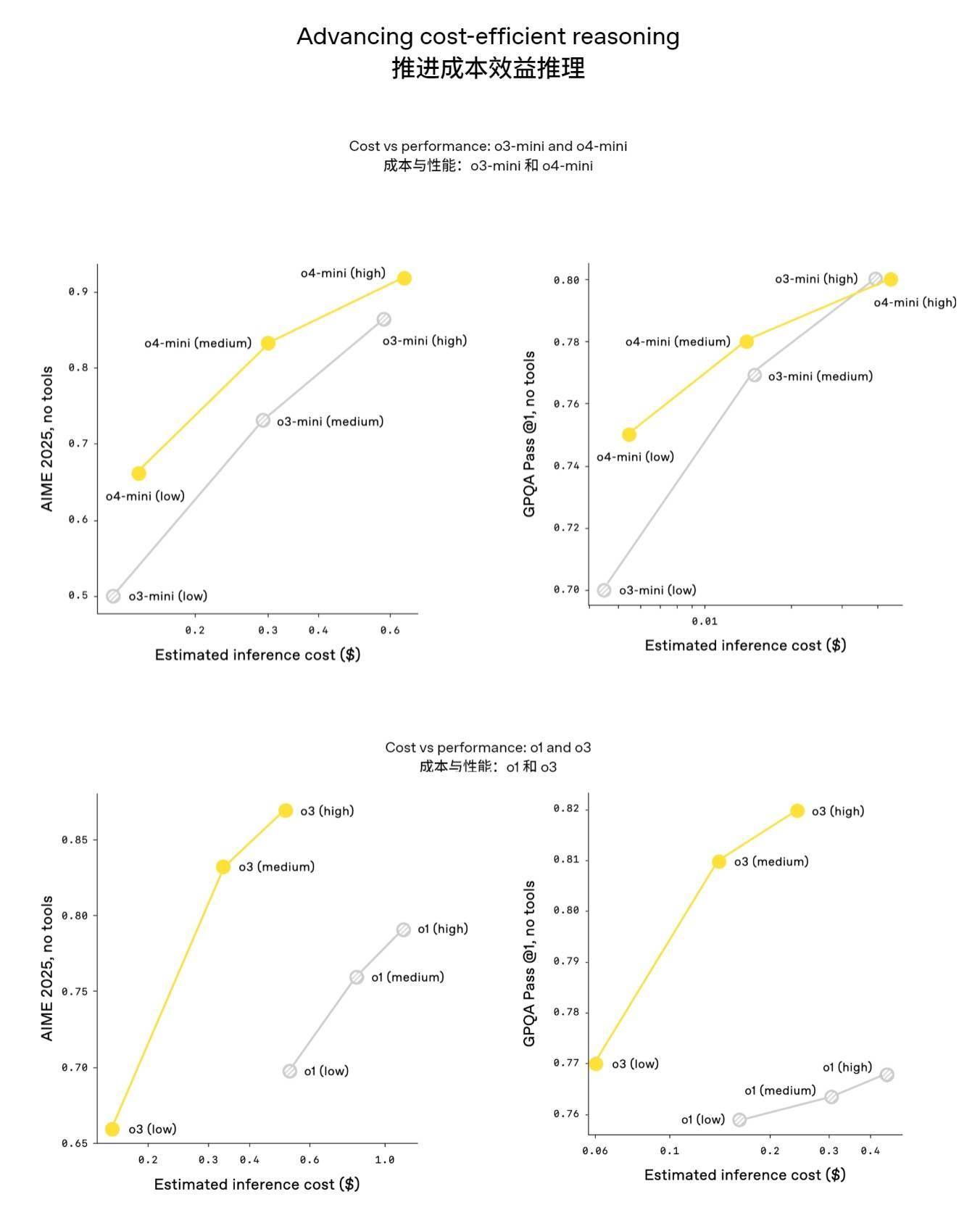

在成本方面,OpenAI声称o3和o4-mini不仅是最智能的模型,而且通常也比o1和o3-mini更高效。例如,在2025 AIME数学竞赛中,o3的性价比优于o1;同样,o4-mini也表现出比o3-mini更高的效率。

在安全性方面,OpenAI对o3和o4-mini进行了全面升级,重建了安全训练数据,并在生物威胁、恶意软件生成和越狱等领域添加了新的拒绝提示。这些更新使得o3和o4-mini在内部拒绝基准测试中取得了优异成绩。OpenAI还开发了系统级缓解措施,以标记前沿风险领域的危险提示,进一步增强了模型的安全性。

对于用户而言,ChatGPT Plus、Pro和Team用户将能够立即在模型选择器中看到o3、o4-mini和o4-mini-high,取代之前的o1、o3-mini和o3-mini-high。ChatGPT Enterprise和Edu用户将在一周后获得访问权限。免费用户则可以在提交查询前选择“思考”来尝试o4-mini。所有计划中的速率限制保持不变。

此次更新不仅展示了OpenAI模型在推理能力上的显著提升,也反映了其将o系列的专业推理能力与GPT系列的自然对话能力和工具使用能力相结合的发展方向。这无疑为人工智能领域注入了新的活力,也让我们对未来的智能应用充满了期待。