英伟达近期在视觉-语言模型领域取得了新突破,推出了名为Eagle 2.5的模型。这款模型专注于长上下文多模态学习,尤其擅长解析大规模视频和图像数据。

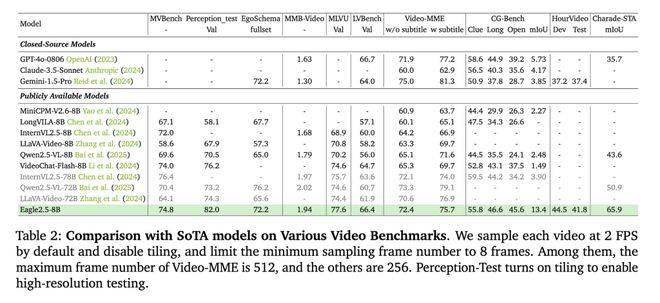

Eagle 2.5虽然参数规模仅为8B,但在处理高分辨率图像和长视频序列时表现优异。在Video-MME基准测试中,该模型以512帧输入取得了72.4%的高分,这一成绩与规模更大的模型如Qwen2.5-VL-72B和InternVL2.5-78B不相上下。

Eagle 2.5的成功离不开其创新的训练策略。首先,信息优先采样策略通过图像区域保留(IAP)技术,确保超过60%的原始图像区域得以保留,同时减少宽高比失真。自动降级采样(ADS)技术能够根据上下文长度动态平衡视觉和文本输入,从而优化文本完整性和视觉细节。

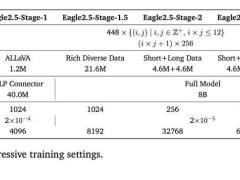

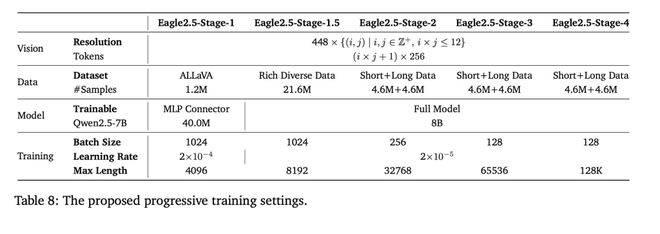

其次,渐进式后训练策略也是Eagle 2.5取得成功的关键。该策略通过逐步扩展模型上下文窗口,从32K到128K token,使模型在不同输入长度下都能保持稳定性能,有效避免了过拟合单一上下文范围的问题。这些策略与SigLIP视觉编码和MLP投影层的结合,进一步提升了模型在多样化任务中的灵活性。

在训练数据方面,Eagle 2.5整合了开源资源和定制数据集Eagle-Video-110K。该数据集专为理解长视频设计,采用双重标注方式。自上而下的方法通过故事级分割,结合人类标注章节元数据和GPT-4生成的密集描述,确保数据的完整性和准确性。自下而上的方法则利用GPT-4为短片段生成问答对,抓取时空细节,进一步提升数据的丰富性和多样性。

通过余弦相似度筛选,Eagle-Video-110K数据集强调数据的多样性而非冗余,确保叙事连贯性和细粒度标注。这一举措显著提升了模型在高帧数(≥128帧)任务中的表现。

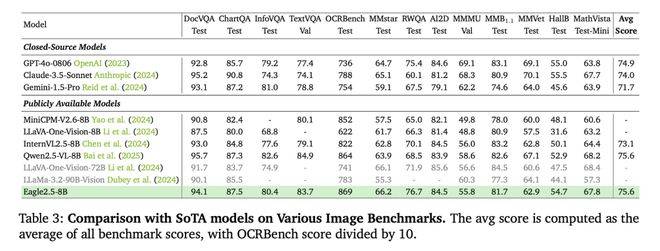

在性能表现方面,Eagle 2.5-8B在多项视频和图像理解任务中均取得了出色成绩。在视频基准测试中,该模型在MVBench、MLVU和LongVideoBench上分别取得了74.8%、77.6%和66.4%的得分。在图像基准测试中,Eagle 2.5-8B在DocVQA、ChartQA和InfoVQA上分别取得了94.1%、87.5%和80.4%的高分。

消融研究表明,IAP和ADS技术的移除会导致模型性能下降,而渐进式训练策略和Eagle-Video-110K数据集的加入则带来了更稳定的性能提升。这些结果进一步验证了Eagle 2.5在视觉-语言模型领域的领先地位。