近日,中信建投证券发布了一份深度报告,详细剖析了DeepSeek R1模型及其在计算力影响方面的表现。该报告全面审视了国内模型在深度推理领域的发展现状,特别是DeepSeek R1模型在这一领域的突出成就。

DeepSeek的R1模型以其强大的深度推理能力引人注目。其中,R1-Zero版本更是通过纯粹的强化学习,证明了大型语言模型仅依赖强化学习同样可以取得显著成果。在此基础上,R1模型经过多次微调和强化学习优化,在数学、编程等复杂推理任务中展现出了卓越的性能。该模型还通过蒸馏技术提升了小模型的推理能力,且成本相对较低。

除了DeepSeek R1,其他模型也在深度推理领域取得了显著成果。例如,Kimi 1.5模型通过长上下文扩展等创新技术,在多模态和推理能力上表现出色。其独特的推理框架和Long2short技术有效优化了计算力需求。同时,阿里的Qwen2.5系列模型也通过构建高质量数据集、改进上下文训练、扩大监督微调数据范围和引入两阶段强化学习等方法,实现了性能的大幅提升,在多个领域处于领先地位。

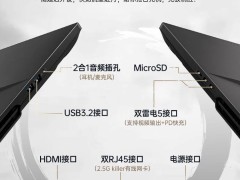

这些模型之所以能够在低算力需求下实现高性能,主要得益于多方面的优化。DeepSeek模型采用了高度稀疏架构、FP8混合精度训练框架、流水线并行策略等先进技术,实现了算法、框架和硬件的协同优化。这些优化措施不仅提高了模型的推理效率,还降低了算力需求。

当前,大模型行业正经历着从生成式向深度推理型的转变。随着这一转变的推进,整体需求也从预训练阶段向后期训练和推理阶段转移。尽管部分模型已经能够在较少的算力下实现高性能,但从长远来看,随着模型的不断发展和深度推理任务的日益复杂,对算力的需求仍将呈现出爆发式增长的趋势。

报告指出,算力是提升人工智能模型性能的关键因素。在未来的深度推理阶段,算力的重要性将更加凸显。因此,如何进一步优化算法、框架和硬件的协同作用,提高模型的推理效率和降低算力需求,将成为大模型行业发展的重要方向。

同时,报告还强调了模型蒸馏等技术在降低算力需求方面的重要作用。通过蒸馏技术,可以将大型模型的复杂知识有效地压缩到小型模型中,从而在保持高性能的同时降低算力需求。这一技术对于推动人工智能技术在更多领域的应用具有重要意义。

报告还展示了多个模型在深度推理任务中的具体表现和数据对比。这些数据不仅验证了模型在深度推理领域的性能优势,也为后续的研究和应用提供了宝贵的参考。

总的来说,中信建投证券的这份报告为我们提供了深入了解DeepSeek R1模型及其在计算力影响方面的宝贵信息。随着人工智能技术的不断发展,我们有理由相信,在未来的深度推理领域,将会有更多创新技术和优化方法涌现,推动人工智能技术的不断进步和拓展应用。